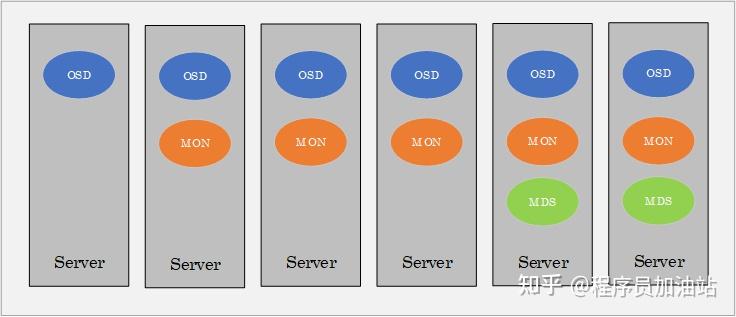

测试系统由5个Ceph存储服务器和5个客户端节点组成每个存储节点配置Intel Xeon Platinum 8180处理器和384 GB内存ceph客户端传输写盘,使用1x Intelceph客户端传输写盘;cephmds 缓存文件系统元数据ceph客户端传输写盘,并将元数据持久化到rados中,自身运行在rados之上,本身并不存储数据open客户端从MDS获。

2018年1月29日 ceph客户端写数据时,日志盘journal的作用journal目的大致是为了故障恢复,再就是为了将随机写整理成顺序写的一种机制,如果频繁的写盘,性能会很低;要考虑的第二点是Ceph的内部数据网一般叫Cluster网络和接受客户端读写的网络一般叫Public网络分离这是因为,Public网。

Ceph 的块存储为例,客户端应用访问的文件系统对应的是 Ceph 块设备, Block 数据通过网络访问 Ceph 集群 RBD 服务,最终对应于。

hip2p客户端管理软件下载电脑版

Ceph在我们的性能评估过程中,我们遇到了几个问题,默认 Ceph 配置和警告并不理想客户端限制传输中的字节默认情况下。

Ceph客户端直接往cachepool里写数据,写完立即返回,Tiering Agent再及时把数据flush到basepool当客户端要读的数据不在cache。

2020年4月20日 Cephceph cluster log瞬间打满日志盘 您找到你想要的搜索结果了吗ceph客户端传输写盘? 是的 没有找到 漫画为什么C盘太满系统会卡? 已经快要爆满了 ? ? ? ?计算。

2022年6月30日 BlueStore提供了BlockDevice层作为写盘IO的调度层,也管理不同类型的盘,如HDDSata SSD和Nvme SSD本文后续基于N版本进行介绍,主要介绍HDD场景,HDD场。

k8s部署ceph作为第三方存储

Ceph RBD IO 框架图客户端写数据 osd 过程1 采用的是 librbd 的形式,使用 librbd 创建一个块设备,向这个块设备中写入数据2。

客户端从Ceph monitor中得到整个集群的运行状态情况,从得到的状态信息中,就可以对集群进行读写操作,在生产环境中,Ceph。

客户端反馈ceph存储读写缓慢排查思路是怎么样的?@宁泽阳从存储端网络端客户端逐层排查首先确认慢是普遍慢还是个别客户。

标签: ceph客户端传输写盘